ในยุคที่สื่อออนไลน์กำลังเฟื่องฟูอย่างมากนี้ หนึ่งในงานที่ Mocap ถูกนำไปประยุกต์ใช้ได้อย่างดีและกำลังเติบโตและเป็นที่นิยมขึ้นเรื่อยๆ นั่นก็คือการทำ ” Vtuber “ หรือการแสดงท่าทาง

ผ่านตัวละครอวตาร์ 3 มิติ โดยการถ่ายทอดสดหรือเรียกว่า Live Steaming ผ่านช่องทางออนไลน์ต่างๆ เช่น Youtube, Facebook, Twitch หรือ platform Live Steaming อื่นๆ ซึ่งตัวละคร

จะเป็นตัวละครแบบต่างขึ้นอยู่กับกลุ่มเป้าหมายของผู้ชม โดยตัวละคร Vtuber นี้เองจะทำหน้าที่เป็นตัวแทนของผู้ที่ทำการ Liveหรือเรียกได้ว่าเป็นการสร้างตัวละครสมมุติให้เป็น influencer ได้

โดยที่ไม่ต้องเผยโฉมหน้าจริงๆของเราเลย โดยสไตล์ของตัวละคร Vtuber ที่นิยมหลักๆในปัจจุบัน คงหนีไม่พ้นตัวละครแนว Anime ที่มีมากมายหลายช่องเลยทีเดียว

แน่นอนว่าข้อดีหลักๆของการทำ ” vtuber ” ก็คือการที่เราสามารถเป็นคนดังได้โดยไม่ต้องเผยโฉมหน้าจริงๆของเรา ทำให้ยังคงความเป็นส่วนตัวได้ โดยแสดงตัวตนผ่านตัวละคร 3 มิติ

ซึ่งหนึ่งในตัวละคร 3 มิติที่มีความเสมือนจริง สามารถนำมาเป็นตัวแทนคนจริงๆได้อย่างดี ที่เราอยากแนะนำนั่นก็คือ Meta Human ที่มีความเสมือนจริงระดับรูขุมขนจาก Epic game

ซึ่งเป็นผู้พัฒนา Software สร้างโลกเสมือนอย่าง Unreal Engine แน่นอนว่าตัว Meta Human เองก็ต้อง Support การทำงานใน Unreal Engine เป็นหลัก ซึ่ง Unreal Engine นี้ที่มีระบบจำลอง

ทางฟิสิกส์ต่างๆ เพื่อเพิ่มพลังการเรนเดอร์ภาพออกมาให้สวยสมจริง ก็ต้องกินทรัพยากรของเครื่องคอมพิวเตอร์เป็นอย่างมาก ทำให้ไม่ใช่ทุกเครื่องคอมพิวเตอร์ที่จะสามารถรัน Unreal Engine

ได้อย่างลื่นไหล วันนี้เราจึงจะมาแนะนำอีกหนึ่งช่องทางเพื่อนำตัว Metahuman นี้เองไปใช้งานในโปรแกรมที่กินทรัพยากรน้อยกว่า มีฟังก์ชันการทำงานรองรับงานแอนิเมชั่นอย่างครบครัน

แถมยังฟรีอีกด้วยอย่าง Blender กัน

หลังจากที่ครั้งก่อน เราได้แชร์ให้เห็นถึงเทคนิคและวิธีการในการส่งข้อมูลแบบ Real time โดยผ่านระบบ Live Steaming ของ Rokoko Studio (ดูได้ที่นี่) ให้ดูกันแล้ววันนี้เราจะนำฟังก์ชั่นนี้

มาใช้กับ Metahuman เพื่อเป็นไอเดียในการ Live Steaming แบบง่ายๆอีกหนึ่งทางสำหรับผู้เริ่มต้นที่สนใจ

Import Metahuman เข้า Blender

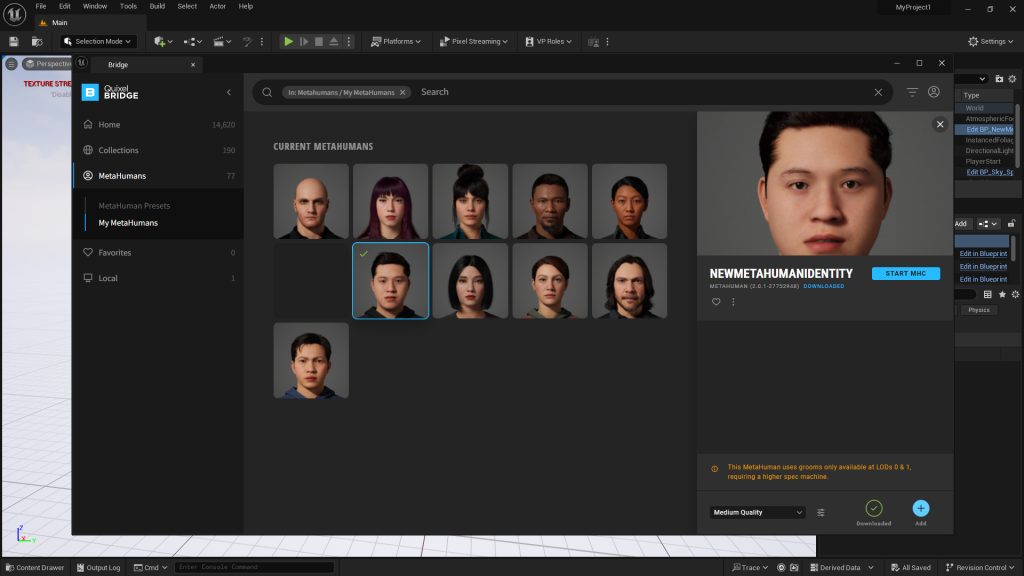

ถึงแม้ว่าเราจะไม่ได้ทำงานบน Unreal Engine เป็นหลักแต่ด้วยการที่ Meta Human Support การทำงานบน Unreal เป็นหลักเราจึงต้องอาศัย Unreal เพื่อทำการ Export ตัวละครซะก่อน

โดยก่อนอื่นก็ Import เข้ามาใน Unreal Engine ผ่าน Quixel Bridge

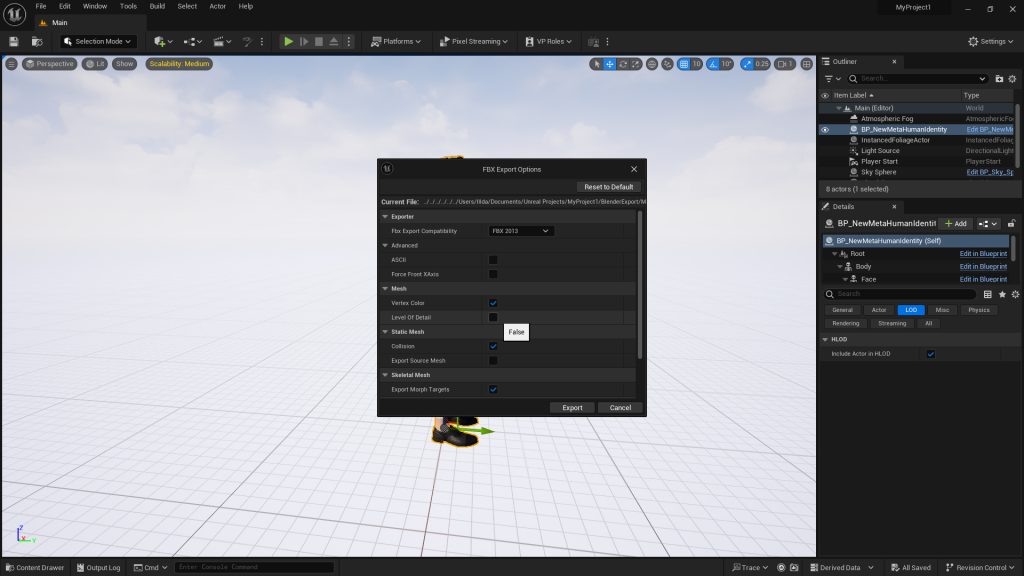

จากนั้นให้ลากตัวละคร Meta Human ของเราเข้าไปใน Scene เพื่อเตรียมการ Export โดยให้เลือกที่ตัวละครจากนั้นไปที่ File>Export Selected และเลือก Format ที่ต้องการ

จะเป็น .fbx หรือ .glb ก็ได้ จะมีหน้าต่างเด้งขึ้นมาให้ตั้งค่าเพิ่มเติม ในแท็บ Mesh ให้เอาติ้กถูกออกในหัวข้อ Level Of Detail ออกเพื่อให้ตัวละครของเรา Export ไปตัวเดียวหากไม่เอาออก

ตัวละครจะถูก Export ซ้อนกันไปหลายตัวในหลายค่าความละเอียดของ Model หากไม่มีอะไรที่ต้องการปรับเพิ่มแล้วก็กด Export ได้เลย

จากนั้นเปิดโปแกรม Blender เลือกวัตถุพื้นฐานใน Scene ทั้งหมดแล้วลบทิ้ง จากนั้นให้ไปที่ File>Import แล้วเลือก Format ที่ต้องการนำเข้าเมื่อเลือกแล้วจะมีหน้าต่างขึ้นมาให้ Brows File

สามารถเลือก Option การ Import เพิ่มเติมได้จากตรงนี้เมื่อเสร็จแล้วกด Import

แก้ไขส่วนที่ไม่สมบูรณ์

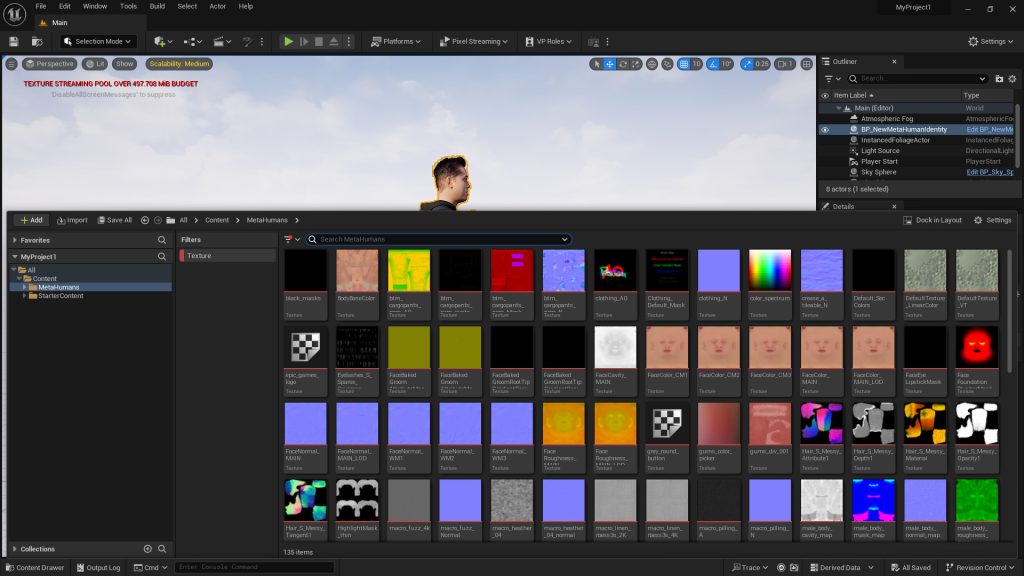

ตัวละครของเราก็จะเข้ามาอยู่ใน Scene โดยจะมี 3 ส่วนหลักๆที่ไม่สามารถส่งมาได้หรือเข้ามาแบบไม่สมบูรณ์จาก Unreal เพราะความต่างของ Software นั่นก็คือส่วนของ Texture ส่วนของผมและคิ้ว

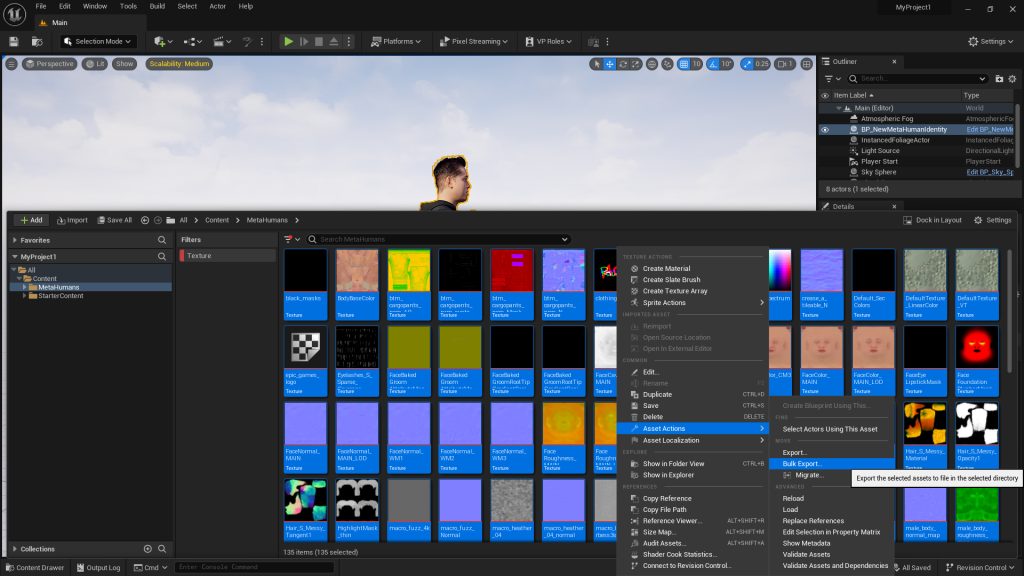

และส่วนของ Rig หรือ Bone ที่เราต้องมาแก้ใหม่เพื่อให้รองรับการทำงานใน Blender อย่างแรกในส่วนของ Texture ให้เปิดใน Content Drawer ของ Unreal แล้วเลือก Filter เป็น Texture

จากนั้นเลือก Texture ทั้งหมดแล้วคลิกขวา Asset Action>Bulk Export เพื่อ Export texture ทั้งหมด ให้เลือก Folder ที่เก็บสำหรับนำไป Link Texture ใหม่ใน Blender

( หาก Import Metahuman เป็น .glb texture จะเข้าBlender ค่อนข้างสมบูรณ์กว่า .fbx )

โดยการ Link Texture ใหม่ใน Blender ให้ไปที่ Mode Shading เพื่อทำการ Create New Material จากนั้นจะมี Node หลักขึ้นมาให้เราเอา Texture มาต่อยัง Chanel ต่างๆได้เลย

( Color, alpha, normal ) จากนั้นทำจนครบทุกส่วนจนสีของ Model เราสมบูรณ์

ในส่วนของเส้นผมเองก็ไปที่ Content Drawer ใน Unreal จากนั้นค้นหา Mesh Hair แล้วเลือก Export Mesh ของเส้นผมที่ LOD_0 หากไม่เจอให้เลือกอันที่ LOD ต่ำที่สุดที่มี

( ยิ่งต่ำ Model ยิ่งละเอียด) จากนั้น Import เข้ามายัง Blender เพื่อให้ตัวละครสมบูรณ์ยิ่งขึ้น หากเส้นผมที่เข้ามาไม่สมจริงเท่าที่ต้องการสามารถใช้เป็นระบบสร้างเส้นผมใน Blender

สร้างขึ้นมาใหม่ก็ได้ (แนะนำวิธีนี้)

ในส่วนของ Rig Bone ที่ส่งออกมาจาก Unreal จะไม่สามารถใช้งานได้ใน Blender ให้เราทำการ Unparent กระดูกทั้งหมดและลบทิ้งจากนั้นสร้างหรือ Rig กระดูกใหม่ เพื่อให้ง่ายเราสามารถใช้กระดูก

จาก Mocap ที่ Export มาจาก Rokoko Studio เพื่อนำมาใช้ Rig กระดูให้ Metahuman ได้

หรืออีกหนึ่งวิธีที่ง่าย และไม่ต้องจัดการ Model มากเหมาะสำหรับมือใหม่นั่นก็คือการใช้ระบบ Auto – Rig บนเว็บ Miamo โดยการอับโหลดตัวละคร Metahuman ของเราขึ้นไป Rig บนเว็บ

แบบอัตโนมัติได้เลย หลังจากที่ Model ทั้งหมดพร้อมแล้ว ทั้งสีและเส้นผมต่างๆ รวมถึงมี Rig ที่พร้อมใช้งานแล้ว อย่าลืมจัดท่า Pose ของตัวละครของเราเป็น T-pose เพื่อให้พร้อมสำหรับการ

Live Streaming จาก Rokoko

Live Streaming จาก Rokoko Studio

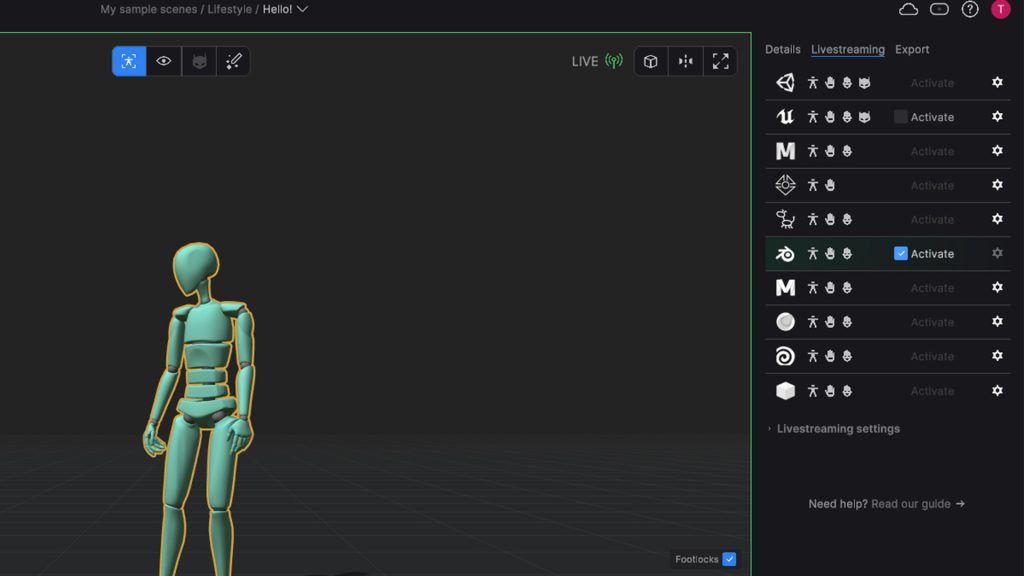

หลังจากที่นักแสดงเชื่อมต่อกับชุด Rokoko Smart Suit Pro II แล้ว ให้ทำการ Calibrate ให้เรียบร้อยจากนั้นในส่วนของระบบ Live Streaming ด้านขวาให้ติ้กถูกหน้าไอคอนโปรแกรม Blender

( หากไม่สามารถติ้กได้ให้กดตั้งค่า Port ก่อน )

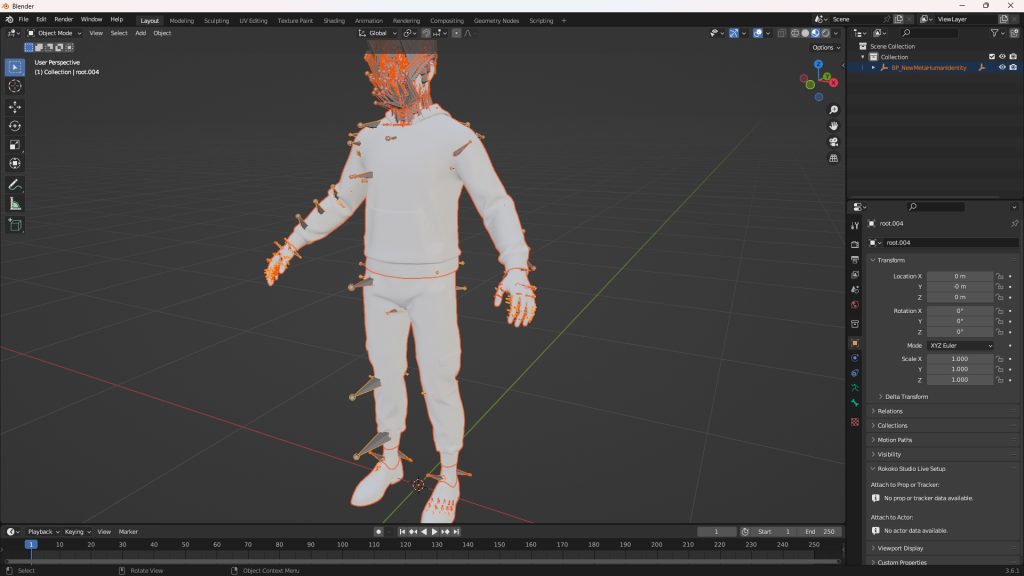

จกานั้นกลับมาที่โปรแกรม Blender โดยต้องติดตั้ง Plugin Rokoko Studio Live For Blender ให้เรียบร้อยก่อน (ดูได้ที่นี่)จากนั้น Login ผ่าน Account ของ Rokoko จากนั้นกดปุ่ม Start Receiver

เพื่อเริ่มรับข้อมูล Mocap ได้เลย

จากนั้นเลือกกระดูกของตัวละครแล้วไปที่ Object Properties ที่แท็บ Studio Live Setup ในช่อง Actor ให้เลือกตัว Actor ของเราใน Rokoko Studio จากนั้นกด Auto Detect เพื่อให้โปรแกรม

ทำการตรวจจับกระดูกอัตโนมัติ ให้เราทำการตรวจสอบว่ากระดูกทั้งหมดได้มีการจับคู่ใน List ได้อย่างถูกต้อง จากนั้นกด Set as T-pose เพียงแค่นี้ตัวละครของเราก็จะเคลื่อนไหวตามชุด Mocap แล้ว

( ทั้งนี้ความละเอียดของการ Live ขึ้นอยู่กับการตั้งค่าการ Preview Render และตัวสเปคของคอมพิวเตอร์ )

ตัวอย่างการ Live Stream ไปยัง Meta Human ใน Blender

-

Rokoko COIL PRO | Ai สำหรับตรวจจับความเคลื่อนไหว Motion Capture

Original price was: ฿129,000.00.฿119,000.00Current price is: ฿119,000.00. Add to cart -

Rokoko Vision (Dual Camera) | Ai สำหรับตรวจจับความเคลื่อนไหว Motion Capture

Original price was: ฿43,900.00.฿39,900.00Current price is: ฿39,900.00. Add to cart -

Promotion

PromotionRokoko HEADRIG | A Professional Motion Capture Head Mount อุปกรณ์สำหรับตรวจจับความเคลื่อนไหวใบหน้า

โปรดสอบถาม Read more -

Promotion

PromotionRokoko HEADRIG + FACE CAPTURE | Promotion A Professional Motion Capture Head Mount

โปรดสอบถาม Read more